Processador de luz classifica dois bilhões de imagens por segundo

Redação do Site Inovação Tecnológica - 09/06/2022

[Imagem: Ella Maru Studio/Penn State]

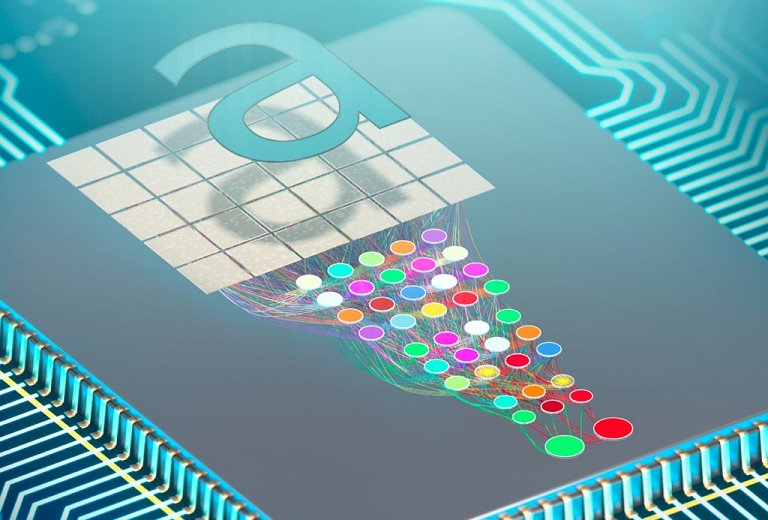

Processador óptico integrado

Engenheiros da Universidade Estadual da Pensilvânia, nos EUA, criaram o que eles afirmam ser primeiro chip neuromórfico escalonável, baseado em tecnologias comerciais, que classifica e reconhece imagens quase instantaneamente.

Este, é claro, não é o primeiro processador neuromórfico e nem mesmo o primeiro a ler sinais ópticos diretamente, mas é o primeiro a colocar tudo dentro de um chip compatível com a tecnologia atual, o que significa que será possível construir rapidamente versões aprimoradas dele para lidar com dados mais complexos.

Para conseguir essa integração, Farshid Ashtiani e seus colegas removeram os quatro principais elementos que consomem tempo nos processadores: A conversão de sinais ópticos (luz) em elétricos, a necessidade de converter os dados de entrada em formato binário, um grande módulo de memória e cálculos sequenciais, baseados no relógio do computador.

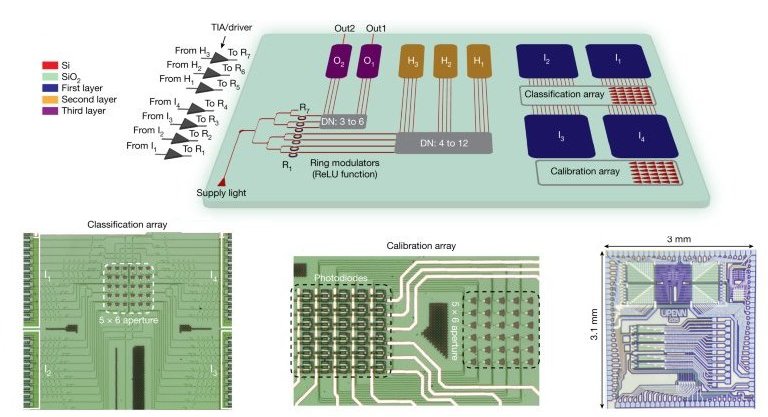

Isto foi possível fazendo o processamento direto da luz recebida do objeto - a imagem - usando uma rede neural óptica profunda, esta por sua vez totalmente implementada dentro de um chip de 9,3 milímetros quadrados.

[Imagem: Farshid Ashtiani et al. - 10.1038/s41586-022-04714-0]

Computação por propagação

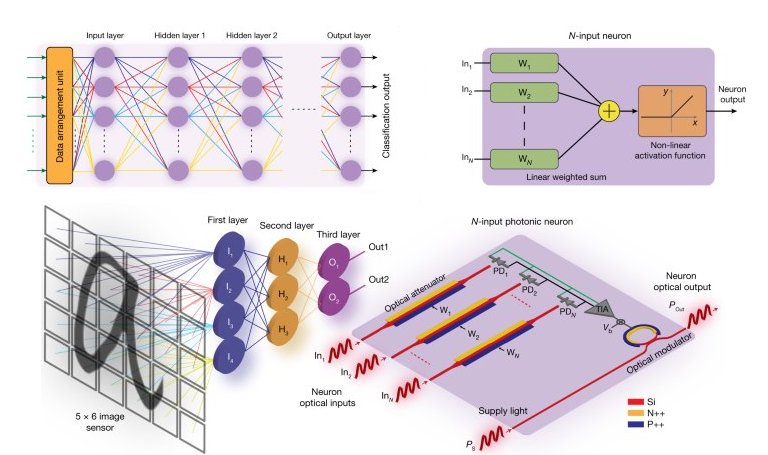

Os neurônios ópticos do processador são interconectados usando guias de onda - pense neles como fios que transmitem luz - para formar uma rede de várias camadas de neurônios, imitando as redes do cérebro humano. As informações passam pelas camadas da rede, com cada etapa ajudando a classificar a imagem de entrada em uma de suas categorias previamente aprendidas.

Como prova de conceito, o processador óptico foi testado em conjuntos de dados contendo dois ou quatro tipos de caracteres manuscritos: Ele alcançou uma precisão de classificação de 93,8% e 89,8%, respectivamente.

Melhor de tudo, a classificação de uma imagem inteira é feita em meio nanossegundo, o que equivale a quase dois bilhões de imagens por segundo. Para comparação, esse tempo (0,5 ns) é o que os processadores eletrônicos tradicionais levam para completar uma única etapa de computação em sua programação baseada em relógio.

"Nosso chip processa informações através do que chamamos de 'computação por propagação', o que significa que, ao contrário dos sistemas baseados em relógio, os cálculos ocorrem à medida que a luz se propaga pelo chip," detalhou o professor Firooz Aflatouni, coordenador da equipe. "Também estamos pulando a etapa de conversão de sinais ópticos em sinais elétricos porque nosso chip pode ler e processar sinais ópticos diretamente, e ambas as mudanças tornam nosso chip uma tecnologia significativamente mais rápida".

E essa capacidade de processar sinais ópticos diretamente tem outros benefícios importantes.

"Quando os chips de computador atuais processam sinais elétricos, eles geralmente os executam por meio de uma unidade de processamento gráfico, ou GPU, que ocupa espaço e energia," disse Ashtiani. "E nosso chip não precisa armazenar as informações, eliminando a necessidade de uma grande unidade de memória. E, ao eliminar a unidade de memória que armazena as imagens, também estamos aumentando a privacidade dos dados."

[Imagem: Farshid Ashtiani et al. - 10.1038/s41586-022-04714-0]

Por que isso é importante?

A inteligência artificial (IA) desempenha um papel importante em muitos sistemas, desde os corretores de digitação até os diagnósticos médicos. Inspirados no cérebro humano, muitos sistemas de IA são implementados com base em redes neurais artificiais, onde equivalentes elétricos ou ópticos dos neurônios biológicos são interconectados, treinados com um conjunto de dados conhecidos, como imagens, e então usados para reconhecer ou classificar novos conjuntos de dados.

Nas redes neurais tradicionais usadas para reconhecimento de imagem, a imagem do objeto é formada primeiro em um sensor de imagem, como o CCD de uma câmera digital. Em seguida, o sensor de imagem converte a luz em sinais elétricos e, finalmente, em dados binários, que podem ser processados, analisados, armazenados e classificados pelos computadores.

Acelerar essas etapas é fundamental para melhorar os aplicativos, como reconhecimento facial e detecção automática de texto, ou ajudar os carros autônomos a reconhecer obstáculos e pedestres.

Embora a tecnologia atual de processadores eletrônicos permita a classificação de imagens realizando bilhões de cálculos por segundo, tornando-a rápida o suficiente para a maioria das aplicações, a necessidade de classificações mais sofisticadas de imagens está movendo o alvo constantemente.

O limite de velocidade atual dessas tecnologias é definido pelo cronograma de etapas de computação baseado em relógio em um processador eletrônico, onde os cálculos ocorrem um após o outro em um cronograma linear. Em um chip óptico, o processamento é feito inteiro de uma vez só, na velocidade da luz.

Artigo: An on-chip photonic deep neural network for image classification

Autores: Farshid Ashtiani, Alexander J. Geers, Firooz Aflatouni

Revista: Nature

DOI: 10.1038/s41586-022-04714-0

Propriedades recordistas do grafeno são encontradas em material 3D

Escultura eletrônica: Componentes têm propriedades ditadas pela geometria

Projetado primeiro detector de grávitons, as partículas da gravidade

Luz é focalizada e desfocada no espaço livre, sem lentes

Dois avanços colocam baterias de estado sólido mais próximas da realidade

Computador neuromórfico conecta matemática, inteligência e neurociência

Buracos de minhoca não existem, Big Bang é um portal e o tempo vai e vem, propõem físicos

Cristal do tempo levita e desafia Terceira Lei de Newton

Tensão de Hubble surge da física real, e não de erros de medição

Bateria de nióbio inédita é criada na USP

Processador fotônico roda por horas a temperatura ambiente

Computador neuromórfico conecta matemática, inteligência e neurociência

Este processador demonstra na prática a computação analógica na memória

Processador inspirado no cérebro surpreende, aprendendo na velocidade da luz

Descoberto sólido que conduz íons tão bem quanto os líquidos

IA feita com luz faz todos os cálculos de uma vez só

Todos os direitos reservados.

É proibida a reprodução total ou parcial, por qualquer meio, sem prévia autorização por escrito.