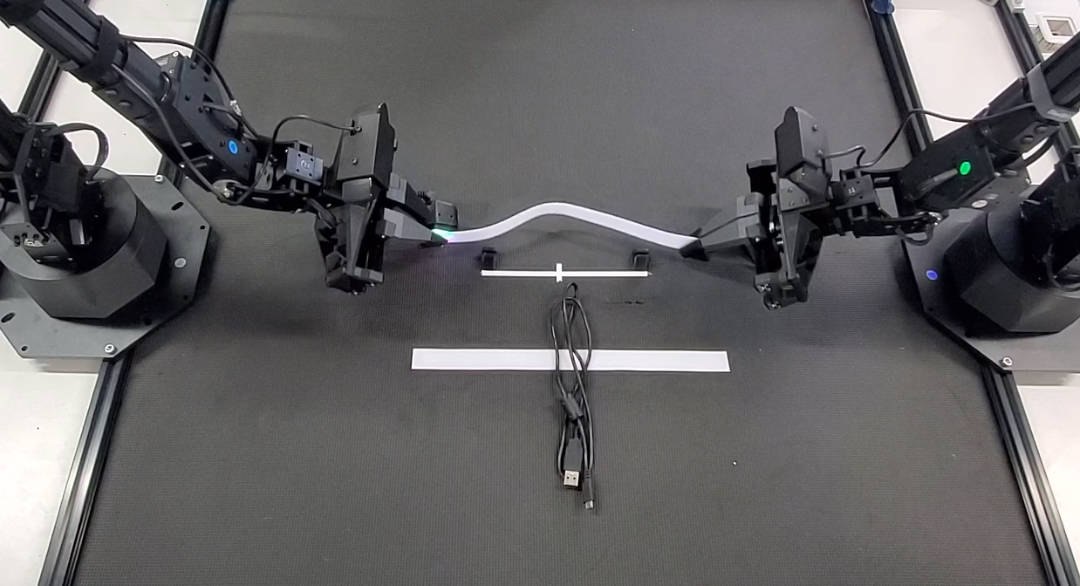

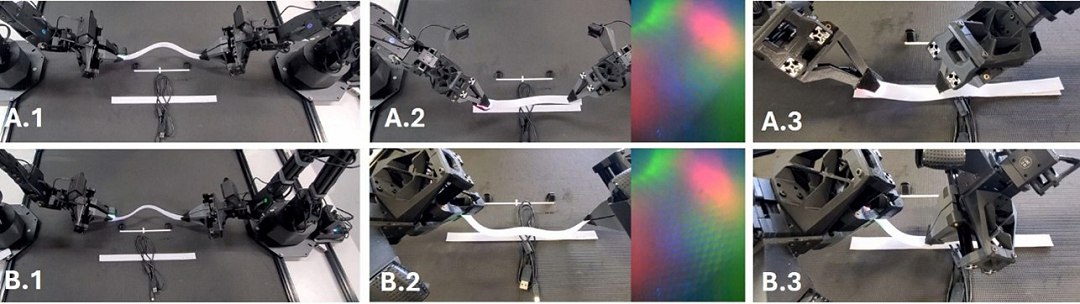

IA física usa visão e tato para manipular objetos como um humano

Redação do Site Inovação Tecnológica - 29/09/2025

[Imagem: Tohoku University]

IA física

Quando pegamos uma xícara de café na mesa, combinamos perfeitamente múltiplas entradas sensoriais, como a visão, que nos dá a distância da xícara, e o tato, que nos permite sentir quando nossa mão faz contato, tudo em tempo real, sem processamento - não precisamos nem mesmo pensar sobre o que estamos fazendo.

Mas recriar isso com robôs, mesmo com a ajuda da inteligência artificial (IA) não tem sido fácil.

Devido às dificuldades encontradas com as tentativas anteriores, uma equipe de Hong Kong e do Japão decidiu adotar uma nova abordagem para integrar informações visuais e táteis, que promete finalmente permitir que mãos e braços robóticos manipulem objetos respondendo de forma adaptativa ao ambiente.

Em comparação com os métodos convencionais, tipicamente baseados em visão artificial, a nova abordagem, que os pesquisadores chamam de física multimodal, alcançou taxas de sucesso mais altas, um avanço significativo no campo da IA incorporada.

O método aprimorado de IA física foi capaz de manipular objetos com precisão, combinando múltiplas entradas sensoriais para gerar movimentos adaptativos e responsivos. A equipe nem se arrisca a listar as aplicações de sua tecnologia, limitando-se a dizer que há "quase infinitas possibilidades de aplicações práticas desses tipos de robôs de auxílio".

[Imagem: Tohoku University]

Robôs com visão e tato integrados

O aprendizado de máquina tem sido usado para dar suporte à inteligência artificial para aprender padrões de movimento humano, permitindo que os robôs realizem tarefas comuns de forma autônoma.

No entanto, esses sistemas dependem principalmente de informações visuais, não possuindo os mesmos julgamentos táteis que um ser humano faz sem pensar, como distinguir a textura de materiais, a frente e o verso de objetos ou se não está pegando na parte quente da xícara de café.

"Para superar essas limitações, desenvolvemos um sistema que também permite decisões operacionais baseadas na textura dos objetos-alvo, que são difíceis de julgar apenas com base em informações visuais," explicou o professor Mitsuhiro Hayashibe, da Universidade de Tohoku. "Essa conquista representa um passo importante para a concretização de uma IA física multimodal que integra e processa múltiplos sentidos, como visão, audição e tato - assim como nós."

Em vez de xícaras de café, a equipe usou como ambiente de teste o fato de que é muito mais fácil identificar a face e o verso de um velcro tocando-o do que discernindo sua aparência, como os sistemas de visão artificial tentam fazer. O sistema robótico de visão e tato integra um sensor tátil para capturar informações de textura de granulação fina, cujas informações são então usadas como suporte à visualização em tempo real feita pelas câmeras. Isso permite lidar com tarefas relacionadas à textura que os métodos baseados em visão de câmera não conseguem.

Usando o novo sistema, o robô de teste conseguiu executar operações bimanuais mesmo em tarefas onde as diferenças frente-trás e a adesividade dos objetos manipulados são cruciais, como com o velcro e com fechamento e abertura de zíper.

Artigo: TactileAloha: Learning Bimanual Manipulation with Tactile Sensing

Autores: Ningquan Gu, Kazuhiro Kosuge, Mitsuhiro Hayashibe

Revista: IEEE Robotics and Automation Letters

DOI: 10.1109/LRA.2025.3585396

Blindagem eletromagnética pode ser instalada em janela transparente

Computação com luz é ótimo, mas como fazer a luz pensar em números negativos?

Como projetar juntas robóticas tão eficientes quanto nossos joelhos

Energia das ondas é extraída com eficiência ótima usando giroscópios

Descoberto material metálico com condutividade térmica recorde

Um feixe de luz vira dois com características completamente diferentes

Processador fotônico roda por horas a temperatura ambiente

Tempo quântico pode ser medido sem um relógio

Cristal do tempo levita e desafia Terceira Lei de Newton

Armazenar dados em DNA é mais fácil do que se pensava

Sinapse artificial de luz impulsiona computação neuromórfica

Computação com luz é ótimo, mas como fazer a luz pensar em números negativos?

Computador neuromórfico conecta matemática, inteligência e neurociência

Este processador demonstra na prática a computação analógica na memória

Processador inspirado no cérebro surpreende, aprendendo na velocidade da luz

Robô move os lábios corretamente quando fala

Todos os direitos reservados.

É proibida a reprodução total ou parcial, por qualquer meio, sem prévia autorização por escrito.