Computação afetiva: É seguro deixar as máquinas reconhecerem suas emoções?

Redação do Site Inovação Tecnológica - 21/10/2025

[Imagem: Site Inovação Tecnológica/Gerado por IA]

Computação afetiva

As máquinas estão chegando cada vez mais perto das inspirações da ficção científica, tanto das utopias, quanto das distopias, destacando de modo um tanto preocupante que a sociedade precisa decidir - e agir - em relação a que futuro deseja quando o assunto é a convivência da humanidade com a tecnologia.

Os pesquisadores Morris Gellisch (Universidade de Zurique, Suíça) e Boris Burr (Universidade Bochum, Alemanha) acabam de demonstrar que, além de saber interpretar instruções linguísticas, os agora onipresentes grandes modelos de linguagem podem se valer apenas dos comandos escritos para entender, interpretar e adaptar suas respostas aos dados fisiológicos e emocionais do ser humano que lhes coloca as questões.

A dupla desenvolveu uma interface técnica por meio da qual os dados fisiológicos podem ser transmitidos ao modelo de linguagem em tempo real. Assim, a inteligência artificial também pode levar em conta sinais fisiológicos sutis, como alterações na atividade cardíaca e biomarcadores de estresse.

O objetivo declarado da pesquisa é abrir caminhos para o uso dos aplicativos de IA em aplicações médicas e de assistência, incluindo o atendimento médico à distância, ou telemedicina. Mas criar máquinas que consigam interpretar e moldar suas respostas tomando por base os estados emocionais das pessoas também levanta inúmeras preocupações éticas e de controle, sobretudo sobre consumidores e funcionários de empresas.

[Imagem: RUB/Kramer]

IA observando suas emoções

Embora tenha de fato um potencial inovador, a chamada computação afetiva levanta preocupações significativas, especialmente no que diz respeito à privacidade, autonomia e potencial de manipulação das pessoas. O risco reside no fato de que as emoções, sendo dados profundamente pessoais e íntimos, podem ser coletadas, armazenadas e utilizadas sem o total conhecimento ou consentimento dos usuários.

É importante lembrar que o conceito de afeto - que dá nome à computação afetiva - na Psicologia é mais amplo e complexo do que o uso comum do termo, geralmente associado apenas a relações positivas de conexão. Na verdade, para os psicólogos o afeto é um conceito genérico que engloba a totalidade das experiências emocionais e sentimentais de uma pessoa.

E as informações coletáveis vão muito além de batimentos cardíacos e ritmos respiratórios, com os que a dupla de pesquisas trabalhou. Por exemplo, uma pesquisa recente mostrou que os pensamentos e intenções podem ser lidos nas expressões faciais, o que pode ser feito por uma câmera comum.

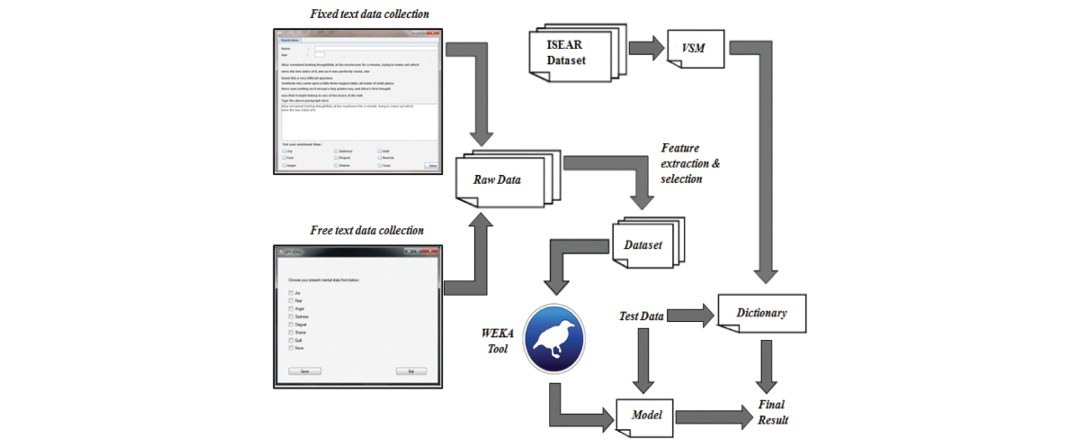

Para seu experimento de demonstração, os dois pesquisadores utilizaram um dispositivo comum que mede a variabilidade da frequência cardíaca por meio de uma cinta torácica. Os dados coletados eram decodificados, filtrados e inseridos no modelo de linguagem GPT-4 em tempo real.

Em resposta a um comando correspondente, a IA conseguiu apresentar corretamente os dados cardíacos transmitidos na formade uma tabela, contendo valores médios, mínimos, máximos e outras informações. "A avaliação e a visualização ocorrem diretamente no ambiente LLM, sem nenhum software estatístico ou de plotagem externo," contou Burr. E, mediante um novo comando de solicitação, a IA também mostrou os dados cardíacos medidos.

"Nós também testamos nosso sistema em uma série de cenários de interação em tempo real, incluindo um experimento sobre estresse cognitivo, no qual o modelo de linguagem adaptou sua saída com base nas reações da frequência cardíaca a demandas menores e maiores," contou Gellisch. O sistema foi capaz de identificar diferenças nos padrões de frequência cardíaca entre tarefas de baixa e alta demanda cognitiva e, em seguida, reagir a essas diferenças na saída da IA. O objetivo era mostrar que o modelo de linguagem pode responder a parâmetros fisiológicos e emocionais em tempo real quando estes são inseridos por meio da interface.

[Imagem: Nahin et al. - 10.1080/0144929X.2014.907343]

Riscos da computação afetiva

"A interface não é interessante apenas para cenários de educação e pesquisa, mas também para aplicações médicas e de saúde, como identificação de estresse, exaustão ou desregulação emocional em tempo real," disse Gellisch.

Se o termo "desregulação emocional", usado acima pelo pesquisador, já abre caminho para excessos de vigilância, os críticos apontam muitas outras possibilidades, da vigilância emocional invasiva e o monitoramento emocional constante, até os riscos de vazamento de dados, os erros de interpretação incorreta e os vieses. Por exemplo, os modelos de IA são treinados com base em conjuntos de dados que podem apresentar viés cultural ou demográfico - uma expressão facial que significa uma coisa em uma cultura, como um sorriso para disfarçar uma emoção, pode ser interpretada de forma errada pelo sistema quando este interagir com pessoas de outra cultura, gerando resultados tendenciosos, injustos e, potencialmente, discriminatórios.

O conhecimento das emoções e intenções de um usuário também abre o caminho para o uso da tecnologia de IA com o objetivo de influenciar o comportamento desse usuário, o que afeta diretamente a autonomia e a livre-escolha das pessoas. As possibilidades de mau uso vão da indução ao consumo e da influenciação política e social até a criação de vínculos danosos, como uma dependência emocional da máquina, que se torna capaz de simular empatia e gerar respostas que criem laços de apego com o usuário, algo que os psicólogos chamam de "ilusão terapêutica".

Outra área de preocupações está no relacionamento das empresas com os empregados. Câmeras e microfones são onipresentes no ambiente empresarial, e programas adequados podem monitorar o engajamento, o estresse ou mesmo a frustração dos funcionários em tempo real, criando mecanismos de avaliação não transparentes. Análises desses dados podem ser usadas como métrica de produtividade, levando a decisões de contratação ou demissão baseadas em "estados de espírito" detectados pela máquina, o que é subjetivo e passível de erro.

Será mesmo isso o que queremos?

Artigo: Establishing a real-time biomarker-to-LLM interface: a modular pipeline for HRV signal acquisition, processing, and physiological state interpretation via generative AI

Autores: Morris Gellisch, Boris Burr

Revista: Frontiers in Digital Health

DOI: 10.3389/fdgth.2025.1670464

Propriedades recordistas do grafeno são encontradas em material 3D

Escultura eletrônica: Componentes têm propriedades ditadas pela geometria

Projetado primeiro detector de grávitons, as partículas da gravidade

Luz é focalizada e desfocada no espaço livre, sem lentes

Dois avanços colocam baterias de estado sólido mais próximas da realidade

Computador neuromórfico conecta matemática, inteligência e neurociência

Buracos de minhoca não existem, Big Bang é um portal e o tempo vai e vem, propõem físicos

Cristal do tempo levita e desafia Terceira Lei de Newton

Tensão de Hubble surge da física real, e não de erros de medição

Bateria de nióbio inédita é criada na USP

Computador neuromórfico conecta matemática, inteligência e neurociência

Este processador demonstra na prática a computação analógica na memória

Processador inspirado no cérebro surpreende, aprendendo na velocidade da luz

Robô move os lábios corretamente quando fala

IA feita com luz faz todos os cálculos de uma vez só

A luz fica inteligente

Todos os direitos reservados.

É proibida a reprodução total ou parcial, por qualquer meio, sem prévia autorização por escrito.